q&A question and answering的缩写,意思是问与答! (将自己不懂的问题,去问题ChatGPTA,获得它的回答) http://home.cutim.top(导航链接)

——————————————————————————————————————————

为什么要使用分布式系统,有啥优点吗?如何将自己写的一个简单java程序作成分布式,最常用的开源分布式实现是啥?

分布式系统是指由多个独立计算机或节点组成的网络,这些节点通过消息传递进行通信和协作。使用分布式系统有以下优点:

- 高性能和可扩展性: 分布式系统可以通过添加更多的节点来扩展计算和存储能力,从而应对不断增长的需求。这有助于提高系统的性能和吞吐量。

- 高可用性和容错性: 分布式系统可以在某些节点故障的情况下继续运行,从而提供更高的可用性和容错性。即使部分节点失效,系统也能保持正常运行。

- 地理分布: 分布式系统允许将计算资源和数据分布在不同地理位置,从而减少延迟并提供更好的用户体验。

- 资源共享: 分布式系统可以共享数据和资源,使多个应用程序能够访问共享的信息,提高了系统的效率。

- 灵活性: 分布式系统可以根据需求调整节点数量和配置,使系统更加灵活适应变化的业务需求。

将简单的 Java 程序变为分布式系统: 将一个简单的 Java 程序变成分布式系统通常需要以下步骤:

- 拆分功能: 将原始程序的不同功能模块拆分为独立的服务或组件。每个服务负责一个特定的功能。

- 通信协议: 设计合适的通信协议,使各个服务可以相互通信和协调工作。

- 数据共享和同步: 确定哪些数据需要在不同的服务之间共享,并实现数据同步机制,确保数据的一致性。

- 负载均衡: 如果有多个实例的服务,考虑如何分配负载,确保每个服务的负载均衡。

- 容错和故障恢复: 实现容错机制,确保一个服务的故障不会影响整个系统,以及故障恢复的策略。

一些常用的开源分布式实现包括:

Apache Hadoop: 用于分布式存储和处理大规模数据集的框架。它包括分布式文件系统 HDFS 和用于批处理的 MapReduce。

Apache Kafka: 用于高吞吐量、持久性的消息传递系统,适用于日志、事件流等场景。

Apache ZooKeeper: 如前所述,用于分布式协调和同步的服务,用于管理配置、命名服务等。

Apache Cassandra: 高度可扩展的分布式 NoSQL 数据库,适用于处理大量数据和高写入负载。

Kubernetes: 用于容器编排和管理的开源平台,可以自动化部署、扩展和管理容器化应用程序。

这些开源工具和框架可以帮助开发人员构建强大的分布式系统,以满足不同的需求和场景。选择适合你项目需求的分布式实现取决于你的应用程序性质和要解决的问题。

——————————————————————————————————————————

Spark 是个啥,有啥作用?底层原理是啥,为什么使用它,类比常用的使用场景?

Apache Spark 是一个快速、通用、可扩展的大数据处理框架,旨在处理大规模数据并支持复杂的数据处理任务。它提供了一种高级 API,可以用于分布式数据处理、机器学习、图计算等多种数据处理任务。

Spark 的作用:

大数据处理: Spark 可以处理大规模的数据集,进行数据清洗、转换、聚合等操作,支持复杂的数据分析和处理任务。

机器学习: Spark 提供了 MLlib 库,用于机器学习任务,包括分类、回归、聚类等,能够在分布式环境下进行大规模的机器学习训练和推断。

图计算: Spark 的 GraphX 库支持图计算,用于处理和分析图结构数据,如社交网络分析、推荐系统等。

流数据处理: Spark Streaming 可以实时处理流式数据,支持流式计算和实时分析。

Spark 的底层原理:

Spark 的核心概念是弹性分布式数据集(Resilient Distributed Dataset,简称 RDD)。RDD 是分布式的、可并行操作的数据集,可以在内存中存储,从而提高数据处理速度。Spark 基于 RDD 实现了一种内存计算模型,允许多个操作在内存中进行,从而避免了频繁的磁盘读写。

Spark 使用了一种称为“转换(transform)和动作(action)”的计算模型。转换操作是指生成一个新的 RDD,而动作操作是触发实际的计算并返回结果。

为什么使用 Spark:

速度: Spark 基于内存计算,相较于传统的 MapReduce 模型,可以大幅提高数据处理速度,尤其在迭代式计算和交互式查询方面。

易用性: Spark 提供丰富的高级 API,包括 Scala、Python、Java 和 R 等,使开发人员能够轻松编写和调试分布式应用。

多种数据处理任务: Spark 不仅支持批处理,还支持流式处理、机器学习和图计算,使其适用于多种数据处理场景。

资源管理: Spark 可以与诸如 Hadoop YARN、Apache Mesos 等资源管理系统集成,有效利用集群资源。

扩展性: Spark 支持在集群上水平扩展,能够处理大规模的数据集。

常用的使用场景类比:

可以将 Spark 比喻为一个强大的工具箱,适用于不同的数据处理需求,类似于一个多功能厨房设备:

如果你需要处理大规模数据,就像准备一顿盛大的宴会,你会用 Spark 来处理和准备数据,就像使用这个设备来切、剁、煮各种食材。

如果你想要训练机器学习模型,就像要制作一道精美的甜点,你会使用 Spark 的 MLlib 库,就像使用工具箱里的烘焙工具。

当你需要分析社交网络或构建推荐系统,就像在料理中添加特殊的调味料,你可以使用 Spark 的 GraphX 库,就像添加独特的调味品。

如果你需要实时处理流数据,就像要即时准备小吃,你可以使用 Spark Streaming,就像用这个设备来迅速烹饪小吃。

综上所述,Spark 是一个强大的大数据处理框架,适用于多种数据处理场景,帮助开发人员高效地处理、分析和利用大规模数据。

—————————————————————————————————————————— Apache Spark 在企业应用中可以实现许多有趣且实用的功能,下面列举了一些例子:

数据分析和报表生成: Spark 可以帮助企业分析大规模数据集,进行数据清洗、转换和聚合,从而生成有关业务运营的报表和洞察。这些报表可以支持决策制定,优化业务流程和资源分配。

实时监控和预测: 使用 Spark Streaming 进行实时数据处理,企业可以实时监控生产环境中的数据流,并基于历史数据进行预测和趋势分析。这对于风险管理、客户行为分析和供应链优化等领域很有帮助。

个性化推荐系统: 利用 Spark 的机器学习库 MLlib,企业可以构建个性化的推荐系统,根据用户的历史行为和兴趣,推荐适合他们的产品、服务或内容,从而提升用户体验和销售额。

欺诈检测: 在金融领域,Spark 可以帮助企业实时监测交易数据,识别潜在的欺诈行为。通过实时处理和分析交易模式,可以快速发现异常交易并采取相应措施。

文本分析和情感分析: 使用 Spark 进行文本数据的处理和分析,企业可以了解用户在社交媒体、评论和反馈中的情感倾向。这有助于评估产品声誉、改进客户支持和洞察市场趋势。

图数据分析: 使用 Spark 的 GraphX 库,企业可以分析社交网络数据、关系图和网络拓扑结构。这对于社交媒体营销、影响者分析和社交网络挖掘非常有用。

批处理数据处理: 对于大规模数据的离线处理,Spark 可以提供高效的批处理功能,用于数据清洗、ETL(Extract, Transform, Load)操作、数据仓库构建等。

大规模机器学习训练: 如果企业需要在大数据集上训练复杂的机器学习模型,Spark 提供了并行处理和内存计算的优势,使得训练任务更加高效。

异常检测和故障预测: 在制造业等领域,利用 Spark 对传感器数据进行分析,可以及早发现生产线上的异常情况,并进行故障预测,从而提高设备利用率和生产效率。

自然语言处理应用: 利用 Spark 进行自然语言处理(NLP)任务,如文本分类、命名实体识别、语义分析等,可以应用于客户支持自动化、内容分析和舆情监控。

——————————————————————————————————————————————————————

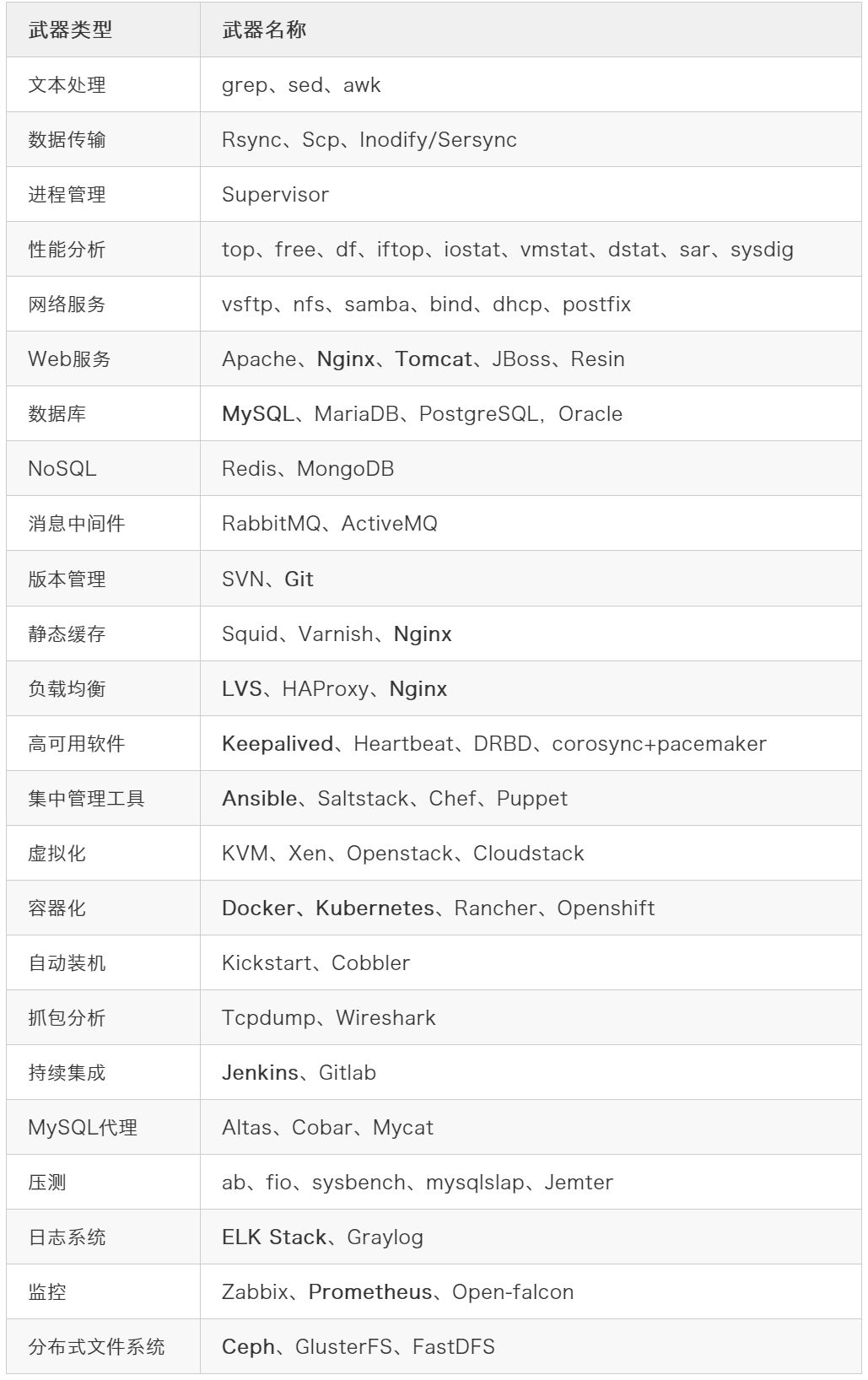

运维工程师需要具备的技能清单

dstat 是一个用于实时系统性能监控的命令行工具,它允许你收集和显示各种系统资源的统计数据,包括 CPU 使用率、内存使用、磁盘活动、网络流量等。dstat 的主要目的是帮助系统管理员和开发人员监视系统的健康状况,识别性能瓶颈和问题,并进行性能调优

系统性能分析:dstat 可以用于实时监视系统的各种性能指标,从而帮助你分析系统的行为和性能。这对于识别性能瓶颈、资源使用不当或者系统异常非常有用。

性能调优:当你需要改进系统的性能时,dstat 可以提供有关资源利用情况的详细信息,以便你可以根据需要进行调整。例如,你可以使用它来确定是否需要增加硬件资源(如 CPU、内存)或者优化应用程序代码。

故障排除:在系统出现问题时,dstat 可以帮助你迅速识别问题的根本原因。例如,如果服务器响应变慢,你可以使用 dstat 来查看是否有异常的 CPU 或内存使用情况,或者是否有异常的磁盘或网络活动。

监视任务:你还可以使用 dstat 来监视特定任务或进程的性能。这对于确保特定应用程序或服务按预期运行非常有用。

示例说明:

以下是一些使用 dstat 的示例:

基本用法:运行以下命令以启动 dstat 并显示默认的性能统计信息:

bash

dstat

这将显示包括 CPU 使用率、内存使用、磁盘活动和网络流量在内的一般性能统计数据。

指定刷新频率和持续时间:你可以使用 -c 选项来指定刷新频率(默认为1秒)和 -t 选项来指定持续时间(默认为无限期),例如:

bash

dstat -c -t 10

这将每秒刷新一次性能统计信息,持续显示10秒。

监视特定磁盘分区:要监视特定磁盘分区的活动,可以使用 -D 选项,例如:

bash

dstat -D sda,sdb

这将显示磁盘分区 sda 和 sdb 的活动情况。

监视特定进程:如果你想监视特定进程的性能,可以使用 -p 选项,例如:

bash

dstat -p -c -d -n -y -l -v

这将显示关于 CPU、磁盘、网络、系统负载等方面的信息,同时监视所有运行的进程。

dstat 提供了丰富的选项和灵活性,以适应不同的性能监视需求。通过分析其输出,你可以更好地理解系统的行为并采取适当的措施来提高性能和稳定性。

sar(System Activity Reporter)是一个用于系统性能监测和性能分析的命令行工具,通常在Unix和Linux系统中使用。它的主要目的是定期采集系统的各种性能数据,并生成报告,以帮助系统管理员和性能分析师了解系统的健康状况、性能趋势和潜在问题。sar 可以监测各种资源,包括CPU使用率、内存使用、磁盘I/O、网络流量等。

示例说明:

以下是一些使用 sar 的示例:

基本用法:运行以下命令以查看默认的系统性能统计信息:

bash

sar

这将显示包括CPU使用率、内存使用、磁盘活动和网络流量在内的一般性能统计数据。

指定特定的性能数据:你可以使用 -u 选项来查看CPU使用率,-r 选项来查看内存使用情况,-d 选项来查看磁盘I/O,-n 选项来查看网络统计数据,例如:

bash

sar -u -r -d -n DEV

这将显示CPU使用率、内存使用、磁盘I/O和网络流量的详细信息。

查看历史数据:你可以使用 -f 选项来查看以前保存的 sar 数据文件,例如:

bash

sar -f /var/log/sa/saXX

这将查看指定数据文件中的性能统计信息,其中 /var/log/sa/saXX 是 sar 数据文件的路径和文件名。

指定时间间隔和次数:你可以使用 -n 选项来指定数据采样的时间间隔和次数,例如:

bash

sar -u 5 10

这将每5秒采样一次性能数据,共采样10次

Postfix 是一个用于邮件传输和邮件服务器的开源邮件传输代理(MTA,Mail Transfer Agent)。它的主要目的是接收、路由和传递电子邮件消息,使邮件能够从一个发件人发送到一个或多个收件人。

使用场景:

电子邮件传输:Postfix 可以用于设置和管理邮件服务器,以便将电子邮件从一个邮件客户端发送到另一个邮件服务器或收件人。这是最常见的用途,适用于个人、企业和服务提供商。

邮件路由:Postfix 具有灵活的邮件路由和策略配置选项,可用于路由电子邮件消息到不同的目标邮件服务器或邮箱。这对于组织内部或跨域邮件流量的管理非常有用。

反垃圾邮件和安全性:Postfix 提供了多种反垃圾邮件和安全性功能,如SMTP认证、SPF(Sender Policy Framework)验证、DKIM(DomainKeys Identified Mail)签名等,可以帮助阻止垃圾邮件和增强邮件的安全性。

邮件队列管理:Postfix 具有强大的邮件队列管理功能,可以帮助处理邮件传输中的问题,如暂时无法传递的邮件,以及管理队列中的邮件。

示例说明:

以下是一些使用 Postfix 的示例:

安装和配置 Postfix:首先,你需要安装 Postfix 并进行基本配置。在大多数Linux发行版中,可以使用包管理工具来安装。例如,在Ubuntu上,可以运行以下命令来安装:

bash sudo apt-get install postfix 随后,你需要编辑 Postfix 的配置文件(通常位于 /etc/postfix/main.cf)来配置域名、邮件路由、反垃圾邮件策略等。

设置邮件域:��置 Postfix 以处理特定域名的邮件。例如,你可以将邮件服务器配置为处理 example.com 域名的邮件。

启动 Postfix 服务:启动 Postfix 服务,使其开始接受和传输电子邮件:

bash sudo systemctl start postfix 发送和接收电子邮件:使用支持SMTP协议的邮件客户端(如Thunderbird、Outlook或命令行工具)来发送和接收电子邮件。配置客户端以使用你的 Postfix 服务器作为出站邮件服务器。

配置反垃圾邮件策略:根据需要配置反垃圾邮件和安全性策略,例如启用SPF验证、DKIM签名等。

监视和管理队列:使用 Postfix 的管理工具来监视和管理邮件队列。例如,使用 postqueue 命令来查看和管理邮件队列中的邮件。

日志和故障排除:Postfix 生成日志文件,用于跟踪邮件传输活动和故障排除。通过分析日志文件,可以识别和解决问题。

Postfix 提供了可扩展性和配置选项,可满足各种邮件传输需求,从小型个人邮件服务器到大型企业级邮件系统。在生产环境中,确保对 Postfix 进行适当的安全配置和维护,以确保邮件传输的稳定性和安全性。

Kickstart是一个定义了Linux安装过程的配置文件,它被设计用来自动化Linux系统的安装过程。通过创建一个kickstart文件,系统管理员可以预先定义系统安装的所有细节,包括时区设置、磁盘分区、软件包选择等。

为什么要存在呢? Kickstart的目的是为了提高Linux系统安装的效率和准确性。通过自动化安装过程,系统管理员可以避免在安装过程中出现人为错误,并且能够确保系统的统一性和一致性。这对于大规模部署和管理多台Linux服务器来说是非常重要的。

具体使用场景包括:

服务器部署:系统管理员可以在单一的kickstart文件中定义所有服务器安装的细节,然后使用这个文件在多台机器上自动化安装Linux系统。这对于快速部署大量服务器非常有用。 版本控制:通过使用kickstart文件,系统管理员可以确保所有安装的系统都使用相同的软件包版本和配置。这有助于保持系统的统一性和避免因不同版本引起的兼容性问题。 自动化测试:开发人员可以使用kickstart文件来定义测试环境的安装要求,然后自动化安装和配置测试环境。这有助于提高测试的准确性和效率。

Jenkins 是一个开源的自动化构建和持续集成(CI/CD)工具,旨在帮助开发团队自动化构建、测试和部署他们的软件项目。它具有强大的插件生态系统,可以与各种不同的开发、构建和部署工具集成,使开发流程更加高效和可靠。

Jenkins 的存在有以下主要目的:

自动化构建:Jenkins 可以自动化执行构建过程,包括编译代码、运行单元测试、生成文档等。这有助于减少手动构建的工作量,降低了潜在的错误和问题。

持续集成:Jenkins 通过持续集成的方式,允许开发团队频繁地集成新的代码变更到共享的代码库中。这有助于减少冲突和问题的出现,提高了团队的协作效率。

自动化部署:Jenkins 可以自动化部署应用程序到不同的环境,例如开发、测试和生产环境。这有助于确保部署过程的一致性,减少了人为错误。

监控和反馈:Jenkins 提供了详细的构建和部署日志,以及通知功能,可以及时通知团队有关构建和部署状态的变化。这有助于快速发现和解决问题。

Jenkins 的具体使用场景可以包括但不限于以下几个方面:

持续集成和持续交付(CI/CD):开发团队可以使用 Jenkins 自动化执行构建、测试和部署流程,确保每次代码提交都经过自动化测试,并能够快速、可靠地部署到生产环境。

定时任务和定时执行:Jenkins 可以配置定时任务,例如每天凌晨执行数据备份、定期生成报告等,从而减少手动干预和监管。

多分支开发:如果团队在多个分支上同时进行开发,Jenkins 可以自动构建和测试每个分支,确保它们的稳定性和可集成性。

自动化测试:Jenkins 可以集成各种测试框架,并在每次构建中运行自动化测试,帮助团队捕获和修复代码问题。

举例说明:假设一个软件开发团队正在开发一个Web应用程序。他们使用 Jenkins 来实现持续集成和持续交付。

每当开发者提交新的代码到版本控制系统(如Git)时,Jenkins 自动触发一个构建任务。

构建任务包括编译代码、运行单元测试、创建可执行文件和部署到测试服务器。如果构建成功,Jenkins 会通知团队,并且可以选择将应用程序自动部署到生产服务器。

如果构建失败,Jenkins 会生成详细的构建日志,帮助开发者快速发现和修复问题。这种自动化流程确保了代码的质量,减少了手动干预,提高了交付速度。

——————————————————————————————————————————————————————

基本知识和技能问答

1.Linux/Unix相关:

- 描述Linux中的文件权限是如何工作的

文件权限在Linux中是通过三种角色(所有者、群组、其他人)以及读、写、执行权限来实现的。每个角色都可以设置文件的不同权限,以控制对文件的访问。

- 日常使用那些Linux命令进行系统性能监控

Linux命令包括top、htop、vmstat等,用于实时监控系统性能

- 解释一下chroot 是什么。以及它的用途

chroot是一种将进程限制在指定目录下运行的方法,用于创建一个隔离的环境,通常用于增加安全性或者在特定环境中运行应用。

2.网络相关:

- 如何查看一个Linux服务器上的网络连接?

使用netstat -a 查询 或者ss 来查询

- 描述TCP和UDP的区别。

TCP (传输控制协议)和UDP (用户数据报协议)都是传输层协议,但是TCP 提供可靠的,面向连接的 通信,而UDP 提供无连接的,不可靠的通信

3.脚本的编写

- 定期备份数据库,并将备份文件上传到云存储

4.工具和平台

哪些配置管理工具的经验,例如Ansible、Puppet、Chef等

Ansible是一款基于代理的配置管理工具,允许自动化配置管理和应用部署

5.安全

如何保护服务器免受未授权访问?

保护服务器免受未授权访问的方法包括禁用不必要的服务、配置防火墙规则,定期更新操作系统和应用程序等

介绍一下SSH key和密码登录的区别及优缺点。 SSH key比密码登录更安全,因为它使用非对称加密来进行身份验证,避免了明文传输密码的风险

————————————————————————————————————————————————————————————————

软件开发设计方面

- 问题1: 请解释什么是 RESTful API?

回答: RESTful API是一种设计风格,用于构建网络应用程序的API。它基于HTTP协议,使用GET、POST、PUT、DELETE等HTTP方法进行通信,通过URL定位资源,并使用状态码进行响应。

- 问题2: 什么是数据库索引?为什么使用它们?

回答: 数据库索引是一种数据结构,用于加速数据库中数据的检索。它通过创建一个特定字段的索引,可以快速定位数据行,提高查询性能,但也会增加插入和更新操作的开销。

————————————————————————————————————————————————————————————————

Javascript 方面的内容

- 解释JavaScript的闭包是什么,以及它的作用。

回答:JavaScript的闭包是一种特性,指的是一个函数可以记住并访问其词法作用域,即使该函数在其词法作用域之外执行。闭包是由函数及其相关的引用环境组合而成的实体。

闭包的作用主要有两个:

封装:闭包可以把函数内部的操作和状态隐藏起来,只允许通过特定的接口与外界交互,从而实现了封装。这有助于保护代码的安全性和稳定性,同时也提高了代码的可维护性。 实现高级函数:闭包可以用来实现许多高级的函数,比如回调函数、柯里化函数、工厂函数等等。这些功能强大的函数可以极大地提高代码的效率和可读性

- 什么是事件委托(Event delegation)?为什么它在Web开发中很有用?

- 解释JavaScript中的同步和异步编程的区别,并给出实际的例子。

- 在JavaScript中,null和undefined有什么区别?

- 如何避免JavaScript中的回调地狱(Callback Hell)?

- 解释JavaScript中的原型继承是如何工作的。

- 什么是AJAX?如何使用JavaScript进行AJAX请求?

- 请解释一下箭头函数(Arrow Functions)在JavaScript中的特点和用法。

- 如何处理JavaScript中的异步错误(Asynchronous Error Handling)?

- 解释什么是事件循环(Event Loop)以及它在JavaScript运行时中的作用。

运维开发方面

- 请介绍一下您之前的运维开发经验,包括您熟悉的运维工具和技术。

- 您如何监控系统的性能和资源利用率,以及如何处理系统瓶颈和故障?

- 您如何进行容量规划和资源管理,以确保系统的可扩展性和稳定性?

- 您如何进行日志管理和故障排查,以及如何快速恢复系统正常运行?

- 您对自动化运维和DevOps有什么了解和实践经验?

- 您对云计算、容器化和虚拟化技术有何了解和实践经验

要求内容

双机组网机制和Nginx的配置

这里涉及到了技术双机冗余的问题,利用 keepalived ,主要确保网络服务的高可使用,通过检测服务器的状态并在服务器之间切换,keepalived 实现了VRRP (Virtual Router Redundancy protocol )实现路由冗余协议

要实现两台Web服务器之间的数据同步,可以使用以下工具和技术:

文件同步工具:使用工具如rsync、scp或Unison等进行文件同步。这些工具可以将文件从一台服务器复制到另一台服务器,并确保两台服务器上的文件保持同步。

数据库复制:如果您使用数据库来存储数据,可以使用数据库复制技术来实现数据的同步。例如,对于MySQL数据库,可以使用主从复制(Master-Slave Replication)或主主复制(Master-Master Replication)来同步数据。

分布式文件系统:使用分布式文件系统如GlusterFS或Ceph可以在多个服务器之间共享和同步文件。这些文件系统提供了高可用性和数据冗余的功能。

数据库集群:使用数据库集群软件如MySQL Cluster、Percona XtraDB Cluster或MariaDB Galera Cluster等可以实现多个数据库节点之间的数据同步和负载均衡。

同步工具和框架:还有一些特定于应用程序的同步工具和框架,可以根据自己的需求进行选择和使用。例如,针对特定的内容管理系统(CMS)或电子商务平台,可能会有专门的插件或模块可用于数据同步。

————————————————————————————————————————————————————————————————

讲一下Keepalived的工作原理?

在一个虚拟路由器中,只有作为MASTER的VRRP路由器会一直发送VRRP通告信息, BACKUP不会抢占MASTER,除非它的优先级更高。当MASTER不可用时(BACKUP收不到通告信息) 多台BACKUP中优先级最高的这台会被抢占为MASTER。这种抢占是非常快速的(<1s),以保证服务的连续性 由于安全性考虑,VRRP包使用了加密协议进行加密。BACKUP不会发送通告信息,只会接收通告信息

Squid、Varinsh和Nginx有什么区别,工作中你怎么选择?

Squid、Varinsh和Nginx都是代理服务器

什么是代理服务器: 能当替用户去访问公网,并且能把访问到的数据缓存到服务器本地,等用户下次再访问相同的资 源的时候,代理服务器直接从本地回应给用户,当本地没有的时候,我代替你去访问公网,我接 收你的请求,我先在我自已的本地缓存找,如果我本地缓存有,我直接从我本地的缓存里回复你 如果我在我本地没有找到你要访问的缓存的数据,那么代理服务器就会代替你去访问公网

区别: 1)Nginx本来是反向代理/web服务器,用了插件可以做做这个副业

但是本身不支持特性挺多,只能缓存静态文件 2)从这些功能上。varnish和squid是专业的cache服务,而nginx这些是第三方模块完成 3)varnish本身的技术上优势要高于squid,它采用了可视化页面缓存技术

在内存的利用上,Varnish比Squid具有优势,性能要比Squid高。 还有强大的通过Varnish管理端口,可以使用正则表达式快速、批量地清除部分缓存 它是内存缓存,速度一流,但是内存缓存也限制了其容量,缓存页面和图片一般是挺好的 4)squid的优势在于完整的庞大的cache技术资料,和很多的应用生产环境

工作中选择: 要做cache服务的话,我们肯定是要选择专业的cache服务,优先选择squid或者varnish。

Tomcat和Resin有什么区别,工作中你怎么选择?

区别:Tomcat用户数多,可参考文档多,Resin用户数少,可考虑文档少 最主要区别则是Tomcat是标准的java容器,不过性能方面比resin的要差一些 但稳定性和java程序的兼容性,应该是比resin的要好

工作中选择:现在大公司都是用resin,追求性能;而中小型公司都是用Tomcat,追求稳定和程序的兼容 Resin 是一个开源的、轻量级的容器平台,用于部署和管理应用程序。它提供了一个简单而强大的方式来构建、部署和扩展应用程序。是一个开源的物联网平台,用于管理和部署嵌入式设备,他是一个基于java 轻量级容器管理平台 Tomcat和Resin都可以作为独立的服务器运行,也可以与其他Web服务器(如Apache)集成使用。它们都支持通过WAR文件或直接将应用程序目录复制到指定位置来部署应用程序。

扎西记录的内容

扎西记录的内容